文| 娱妮啵啵

编辑| 娱妮啵啵

本文陈述所有内容,皆有可靠来源

序

如果你接到一个视频电话,屏幕里是熟悉的面孔,亲切的声音,你会猜疑对方是假的吗?

恐怕大多数人都不会。然而,在这个AI技术日新月异的时代,“眼见为实”已经不再可靠。

骗子们正在利用最前沿的人工智能技术,掀起一场前所未有的诈骗革命。

想象一下,你的好友、亲人,甚至是你的老板,突然出现在视频通话中。

向你求助或发出指令。他们的表情、动作、声音,无一不是你熟悉的样子。

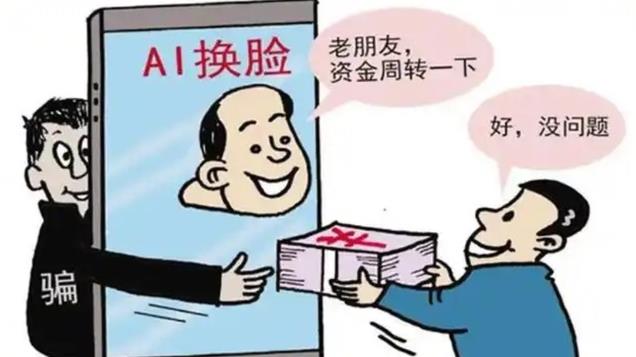

你会怀疑吗?恐怕很难。这就是AI换脸诈骗的可怕之处。

它几乎完美地复制了真实的人,让受害者无从分辨真伪。

更令人担忧的是,这种新型诈骗的成功率几乎达到了100%。

毕竟,当你亲眼所见、亲耳所闻都无法相信时,还有什么可以相信呢?

那么,面对如此高明的骗术,我们是否就只能束手就擒?

是否真的无法识破这些数字世界中的“完美骗局”?

这个令人不寒而栗的AI换脸诈骗,看看在这场人类与技术的较量中,我们还有哪些自保之道。

又有新骗局

科技的进步不仅改变了我们的生活方式,也推动了诈骗手段的演变。

从最初的电话诈骗到短信诈骗,再到如今的网络诈骗,骗子们总是紧跟技术潮流,不断更新他们的犯罪手法。

而今,一种更为高级、更难防范的诈骗方式悄然崛起——AI换脸诈骗。

回首过去,我们还在为“传统”的电信诈骗和冒充公检法诈骗而烦恼。

骗子们装扮成亲友或权威人士,通过电话或短信编织谎言,试图骗取我们的信任和钱财。

虽然这些骗局屡见不鲜,但只要我们保持警惕,仔细核实,通常还是能识破的。

可AI换脸诈骗的出现让传统的防骗经验几乎失效。

上一年,福建省一家科技公司的法人郭先生就栽在了这种新型骗局上。

他接到一个“老朋友”的视频来电,对方表示急需430万元作为项目竞标保证金。

由于需要对公账户走账,所以想请郭先生帮个忙。

视频通话再加上不管是人脸还是声音都和真人没有任何差别,他想都没想毫就转账了。

一直到后来和真正的朋友取得联系才发觉自己视频中见到的“朋友”是个不折不扣的骗子。

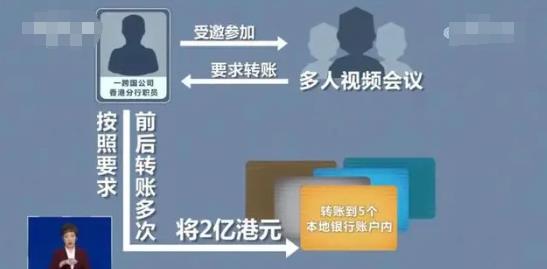

今年香港就发生了一起惊人案例:一名公司职员参与了一场看似普通的“多人视频会议”。

却在不知不觉中被诱导将高达2亿港元的巨款转入了5个本地银行账户。

警方介入调查后,揭开了这场骇人听闻的骗局。

除了受害者本人,会议中的其他“参会者”竟全是AI换脸技术制造的虚拟人物!

这起案件令人不寒而栗,它展示了AI换脸诈骗的恐怖之处。

不仅能以假乱真地复制单个熟人的形象和声音,更能模拟出复杂的多人互动场景。

受害者在毫无戒心的情况下,就这样步入了精心设计的陷阱。

这些案例让我们不得不警惕:在AI时代,“眼见为实”已经不再可靠。

那么,这种高科技诈骗手段是如何实现的呢?

骗子们的新技术

骗子们需要收集目标人物的照片和视频素材。

这些素材可能来自社交媒体平台、公开的新闻报道,甚至是通过黑客手段窃取的私人文件。

有了这些素材,他们就能够利用手上的AI进行深度学习技术。

“制造”出一个和目标人物面部表情和动作几乎没有差别的模型。

接下来,骗子们会使用实时换脸技术,将这个模型应用到视频通话中。

这意味着,当他们与受害者进行视频通话时。

受害者看到的将是一个栩栩如生的“数字分身”,而非真实的骗子。

不仅如此,AI技术还能够模仿目标人物的声音。

AI不仅能复制一个人的音色和语调,还能模仿说话的节奏、停顿和语气变化。

甚至一些独特的口头禅或习惯性的咳嗽声,都能被精确复制。

这种技术的精湛程度已经到了连亲密的家人都难以分辨的地步。

有趣的是,这种技术的逼真程度甚至超过了我们对自己的认知。

曾有实验让人们辨别自己的真实录音和AI合成的声音。

结果发现许多人反而认为AI合成的声音更像自己。

这种现象说明,AI不仅能模仿我们的声音,还能在某种程度上“优化”它。

使其听起来更加清晰和“标准”。

更可怕的是,这种技术正在变得越来越容易获取和使用。

一些公开的AI换脸软件已经能够实现较为逼真的效果。

而专业的犯罪团伙则可能拥有更加先进的技术。这意味着,潜在的受害者群体正在不断扩大。

那么,面对如此高明的诈骗手段,我们该如何保护自己呢?

如何保住钱袋子?

骗子们为了“有业绩”可以说是无所不用其极,谁能想到这年头的骗子也用上了高科技。

几乎是毫无破绽的技术让不少网友忧心忡忡。

毕竟谁都怕辛辛苦苦的血汗钱,最后被几句话骗得一干二净。

不过面对这些骗子,咱们也不是一点办法都没有,提高警惕这是毋庸置疑的。

不要轻易相信单一渠道的信息。

就算是视频里看到自己熟悉的面孔,也不要就这样信以为真,不假思索的对对方有求必应。

一定要用其他的办法再进行核实。

比如,可以打电话给对方的其他联系方式,或者通过亲友圈询问。

对于金钱上的来往要层层验证,无论对方是谁,都应该多方核实。

并且遵循“宁可信其有,不可信其无”的原则。

如果对方要求紧急转账,更要提高警惕,因为这往往是诈骗分子惯用的手法。

我们不被骗,也要避免骗子用自己的信息去骗身边的家人朋友。

最有效的方式就是尽量不要在网上公开发布自己的照片和视频。

特别是一些可能被用于AI训练的高清正面照。

同时,也要注意保护自己的社交媒体账号安全,避免被黑客入侵。

当然如果真的遇到了有身边的亲人朋友打视频借钱,咱们也可以利用一些小技巧来辨别真伪。

毕竟尽管现在骗子们的技术在不断进步,可目前的AI换脸视频仍然存在一些细微的瑕疵。

比如,眨眼频率不正常,嘴唇与声音会有“时差”出现不同步。

再或者面部某些细节处理得不够完美。通过仔细观察,我们可能会发现一些蛛丝马迹。

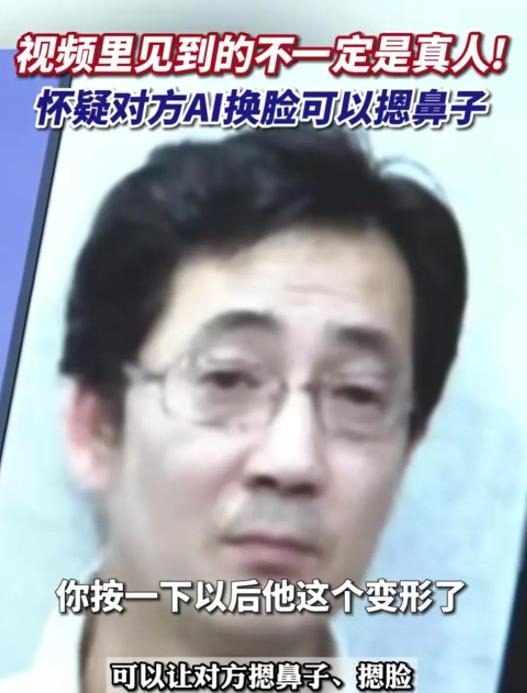

对于一些重要的视频通话,我们可以要求对方做一些特定的动作,比如摸摸鼻子、举起手等。

这些随机的动作可能会让AI换脸技术难以及时反应,从而暴露破绽。

面对日益猖獗的AI换脸诈骗的威胁,我们也没有坐以待毙。

反诈部门正在积极研发AI换脸检测技术,未来可能会推出一些能识别伪造视频的智能工具。

我们应该密切关注这些技术进展,及时学习使用,为自己筑起一道防护墙。

若不幸落入骗局,切记第一时间报警。

同时,要尽可能详细地记录事件经过,保留相关证据,全力配合警方调查。

只有警民携手,才能更好地打击这类高科技犯罪,维护社会安全。

记住,在这场与AI诈骗的博弈中,我们每个人都是前线战士。

参考信息:文县公安2024.12.13——《一张照片可实时视频换脸!警惕AI合成这种新型网络诈骗手段》

湖南公安2024.2.29——《被骗2亿!男子参加多人视频会议,结果真人只有他自己!》

福州晚报2023.5.23——《当心这张脸!福州一老板被骗430万元》

发表评论:

◎欢迎参与讨论,请在这里发表您的看法、交流您的观点。